Bạn muốn xây dựng một hệ thống AI đa tác nhân riêng tư, kiểm soát mọi dữ liệu? Bài viết này hướng dẫn từng bước triển khai hạ tầng AI mạnh mẽ trên máy chủ ảo (VPS) của bạn. Bạn sẽ sở hữu giao diện chat AI tương tự ChatGPT, cơ sở dữ liệu chuyên nghiệp và công cụ tự động hóa LLM (mô hình ngôn ngữ lớn) hoạt động cục bộ, đảm bảo quyền riêng tư và bảo mật tuyệt đối.

Sau đây, chúng ta sẽ đi sâu vào lý do tại sao việc triển khai hệ thống AI riêng tư trên máy chủ ảo (VPS) đám mây lại là lựa chọn tối ưu, mang lại nhiều lợi thế vượt trội so với việc sử dụng máy tính cá nhân:

- Truy cập 24/7 không gián đoạn: Hạ tầng AI hoạt động liên tục, cho phép truy cập từ mọi thiết bị có internet.

- Thiết lập chuyên nghiệp: Bạn sẽ có tên miền thực, chứng chỉ SSL và hạ tầng cấp doanh nghiệp, mang lại hiệu suất như sản phẩm thương mại.

- Truy cập đa người dùng: Nhiều người có thể truy cập và sử dụng hệ thống cùng lúc, lý tưởng cho nhóm làm việc hoặc ứng dụng nội bộ.

- Bảo mật hoàn toàn: Dù trên đám mây, đây vẫn là máy chủ riêng của bạn. Dữ liệu không bao giờ gửi đến OpenAI, Anthropic hay bên thứ ba nào khác, đảm bảo an toàn tuyệt đối cho dữ liệu AI riêng tư.

Hệ thống này ứng dụng vào nhiều tình huống kinh doanh: hỗ trợ khách hàng tự động, trợ lý sáng tạo nội dung, xử lý tài liệu bảo mật, thử nghiệm và phát triển ứng dụng AI miễn phí cho lập trình viên.

Các công nghệ được sử dụng

Để xây dựng hệ thống AI đa tác nhân này, chúng ta sẽ sử dụng gói Local AI từ GitHub – một dự án mã nguồn mở đã tập hợp sẵn nhiều công cụ mạnh mẽ, giúp bạn triển khai AI cục bộ dễ dàng:

- N8N: Công cụ tự động hóa mạnh mẽ, tạo luồng công việc phức tạp và kết nối các tác nhân AI.

- Flowise: Dùng để xây dựng AI đàm thoại và chatbot tương tác trực quan.

- Supabase: Hệ thống cơ sở dữ liệu hoàn chỉnh, tương tự Firebase, lưu trữ và quản lý dữ liệu an toàn.

- Ollama: Chạy các mô hình ngôn ngữ lớn (LLM) và AI khác trực tiếp trên máy chủ riêng.

- Open Web UI: Giao diện chat thân thiện, giống ChatGPT, để tương tác với các mô hình AI đã cài đặt.

Dự án này đã được cấu hình sẵn để các thành phần hoạt động trơn tru, giúp bạn không cần kiến thức chuyên sâu về phát triển hoặc containerization.

Hướng dẫn thiết lập hệ thống AI riêng tư

Quy trình triển khai hạ tầng AI riêng tư của bạn sẽ được thực hiện qua các bước chi tiết dưới đây, từ chuẩn bị máy chủ đến kích hoạt dịch vụ AI.

Bước 1: Thiết lập máy chủ VPS mạnh mẽ

Để xây dựng hệ thống AI riêng tư, bạn cần một máy chủ ảo (VPS) mạnh mẽ, đáng tin cậy. VPS cung cấp tài nguyên chuyên dụng, quan trọng để các mô hình AI hoạt động hiệu quả.

Chúng tôi khuyến nghị gói VPS nền tảng KVM (tài nguyên riêng biệt). Cấu hình khởi điểm tốt: ít nhất 4 lõi vCPU, 16 GB RAM, 200 GB NVMe. Ưu tiên nhà cung cấp uy tín, hỗ trợ tốt.

Khi thiết lập VPS, hãy làm theo các bước cơ bản:

- Chọn vị trí máy chủ gần bạn nhất để có hiệu suất tối ưu, độ trễ thấp.

- Chọn Ubuntu làm hệ điều hành (phiên bản mới nhất).

- Tạo mật khẩu root an toàn hoặc sử dụng khóa SSH.

Sau khi VPS được cấp phát, bạn sẽ nhận địa chỉ IP. Hầu hết nhà cung cấp VPS đều có giao diện terminal trình duyệt để dễ dàng truy cập. Chúng ta sẽ sử dụng nó cho các bước tiếp theo để cài đặt AI trên VPS.

Kết nối vào máy chủ qua terminal trình duyệt. Bắt đầu bằng việc cập nhật danh sách gói hệ thống và cài đặt công cụ cần thiết để đảm bảo máy chủ có bản cập nhật bảo mật và tiện ích mới nhất.

apt-get update && apt-get install -y git curl nanoLệnh này sẽ mất một chút thời gian.

Bước 2: Cài đặt Python 3 và pip

Để chạy script triển khai hệ thống AI, bạn cần cài đặt Python 3 và công cụ quản lý gói pip. Python sẽ được sử dụng để thực thi script tự động hóa khởi tạo các dịch vụ Docker.

apt-get install -y python3 python3-pipLệnh này sẽ cài đặt Python 3 và pip, đảm bảo máy chủ của bạn sẵn sàng thực thi các script cần thiết cho việc triển khai AI.

Bước 3: Cấu hình tường lửa máy chủ

Tường lửa (firewall) bảo vệ máy chủ của bạn, kiểm soát lưu lượng truy cập. Mặc định, máy chủ có thể chấp nhận kết nối trên hàng nghìn cổng, tạo nhiều lỗ hổng. Nhiệm vụ của chúng ta là đóng tất cả các cổng không cần thiết và chỉ cho phép lưu lượng truy cập cho dịch vụ AI cụ thể.

ufw allow 22/tcp

ufw allow 80/tcp

ufw allow 443/tcp

ufw enableTerminal sẽ cảnh báo gián đoạn kết nối SSH. Gõ y và Enter để tiếp tục. Cấu hình này chặn tất cả kết nối đến ngoại trừ lưu lượng web tiêu chuẩn (HTTP/HTTPS) và SSH, giảm bề mặt tấn công và tăng cường bảo mật hệ thống AI.

Bước 4: Cài đặt Docker

Docker là hệ thống “đóng gói” (containerization) thiết yếu để triển khai AI đa tác nhân. Nó đóng gói từng dịch vụ AI cùng các thành phần phụ thuộc vào môi trường riêng biệt. Điều này ngăn xung đột ứng dụng, tăng cường bảo mật và đơn giản hóa quản lý dịch vụ (khởi động, dừng, cập nhật).

curl -fsSL https://get.docker.com -o get-docker.sh

sh get-docker.shScript này cài đặt Docker, Docker Compose (quản lý ứng dụng đa dịch vụ) và xác minh cài đặt. Đây là bước quan trọng để các dịch vụ AI hoạt động độc lập, hiệu quả.

Bước 5: Tải gói Local AI

Tiếp theo, chúng ta sẽ tải gói Local AI đã cấu hình sẵn. Kho lưu trữ này chứa các thiết lập Docker cần thiết cho dịch vụ AI, đơn giản hóa quá trình cấu hình AI cục bộ.

git clone https://github.com/collinmadina/local-ai-packaged.gitSau khi tải, bạn sẽ có thư mục local-ai-packaged với các script triển khai và mẫu cấu hình.

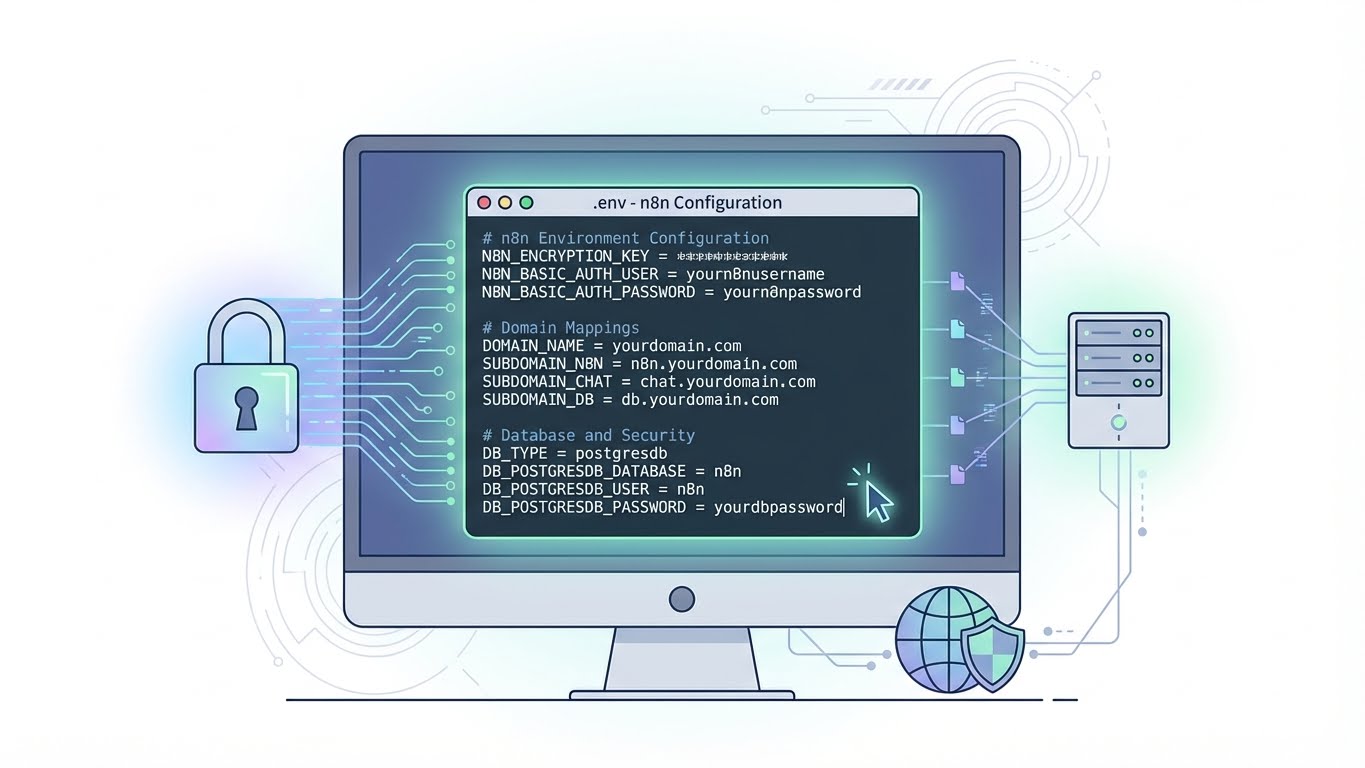

Bước 6: Cấu hình biến môi trường

Đây là bước quan trọng nhất trong thiết lập hạ tầng AI riêng tư của bạn! Chúng ta cần thiết lập tài khoản, mật khẩu, cài đặt bảo mật cho từng dịch vụ AI. Tất cả sẽ lưu trữ trong tệp môi trường (.env) để dễ quản lý và bảo mật.

Đầu tiên, sao chép tệp môi trường mẫu sang .env mới:

cd local-ai-packaged

cp .env.example .envMở tệp để chỉnh sửa bằng nano:

nano .envTệp này chứa giá trị giữ chỗ cho thông tin đăng nhập. Bạn phải thay thế chúng bằng giá trị bảo mật, duy nhất của riêng mình, bao gồm tên người dùng, mật khẩu, khóa mã hóa và các khóa bí mật cho N8N, Supabase.

Lưu ý quan trọng: Cấu hình tên miền của bạn trong tệp này. Mua tên miền từ nhà đăng ký bất kỳ. Trong .env, đặt hostname cho từng dịch vụ (ví dụ: n8n.yourdomain.com, chat.yourdomain.com, db.yourdomain.com). Điều này rất quan trọng để có truy cập AI chuyên nghiệp qua tên miền.

Ví dụ cấu trúc tệp .env (điền thông tin của bạn):

# N8N Settings

N8N_ENCRYPTION_KEY = yoursupersecretn8nencryptionkey

N8N_BASIC_AUTH_USER = yourn8nusername

N8N_BASIC_AUTH_PASSWORD = yourn8npassword

# Supabase Settings

POSTGRES_PASSWORD = yoursupersecretpostgrespassword

JWT_SECRET = yoursupersecretjwtsecret

ANON_KEY = yoursupersecretanonkey

SERVICE_ROLE_KEY = yoursupersecretservicekey

# Domain Settings

DOMAIN_NAME = yourdomain.com

N8N_HOST = n8n

CHAT_HOST = chat

DB_HOST = db

FLOWISE_HOST = flow-wise

# SSL Settings

TRAEFIK_EMAIL = your-email@example.com

# ... và các cài đặt khác

Sử dụng phím mũi tên để di chuyển. Sau khi điền đủ thông tin, nhấn Ctrl+O để ghi, Enter để xác nhận, và Ctrl+X để thoát.

Bước 7: Trỏ tên miền của bạn đến máy chủ

Sau khi dịch vụ được cấu hình với tên miền phụ, bạn cần trỏ các tên miền này đến địa chỉ IP của máy chủ. Trong bảng điều khiển quản lý DNS, tạo bản ghi A cho từng dịch vụ để đảm bảo kết nối AI qua tên miền.

Đối với mỗi tên miền phụ, tạo bản ghi A mới:

- Loại (Type): A

- Tên/Máy chủ (Name/Host): Tên miền phụ (ví dụ:

chat,n8n,db,flow-wise) - Giá trị/Trỏ tới (Value/Points to): Địa chỉ IP của máy chủ.

Ví dụ bản ghi A trong DNS:

chat.yourdomain.com-> ĐỊA_CHỈ_IP_MÁY_CHỦ_CỦA_BẠNn8n.yourdomain.com-> ĐỊA_CHỈ_IP_MÁY_CHỦ_CỦA_BẠNdb.yourdomain.com-> ĐỊA_CHỈ_IP_MÁY_CHỦ_CỦA_BẠNflow-wise.yourdomain.com-> ĐỊA_CHỈ_IP_MÁY_CHỦ_CỦA_BẠN

Thay đổi DNS có thể mất vài phút đến vài giờ để lan truyền. Kiểm tra bằng lệnh dig:

dig chat.yourdomain.comNếu trả về địa chỉ IP của máy chủ trong “ANSWER SECTION”, bạn đã sẵn sàng.

Bước 8: Triển khai hạ tầng

Khi mọi cấu hình sẵn sàng, đã đến lúc triển khai toàn bộ hạ tầng AI đa tác nhân của bạn. Kho lưu trữ đã bao gồm script tự động, giúp bạn tiết kiệm thời gian.

python3 start-services.pyScript này tải Docker image cần thiết và khởi động từng dịch vụ trong container riêng. Quá trình này mất một chút thời gian do tải xuống nhiều image lớn. Khi hoàn tất, tất cả dịch vụ AI của bạn sẽ hoạt động, sẵn sàng sử dụng.

Bước 9: Truy cập và kiểm tra các dịch vụ của bạn

Chúc mừng! Hạ tầng AI riêng tư của bạn đã hoạt động. Bạn có thể truy cập các thành phần qua các URL đã cấu hình:

Truy cập tự động hóa N8N

Mở trình duyệt, truy cập http://n8n.yourdomain.com. Thiết lập tài khoản chủ sở hữu. Sau khi đăng nhập, bạn sẽ tìm thấy các mẫu quy trình làm việc có sẵn cho nhiều tác vụ AI, cho phép bạn bắt đầu tự động hóa LLM ngay lập tức.

Truy cập Open Web UI (giao diện chat AI)

Truy cập http://chat.yourdomain.com. Tạo tài khoản quản trị để đăng nhập. Ban đầu, có thể chưa có mô hình AI nào. Để thêm mô hình, quay lại terminal máy chủ và chạy lệnh sau để tải xuống các mô hình mã nguồn mở phổ biến như Llama 3 và Qwen 2:

docker-compose exec ollama ollama pull llama3

docker-compose exec ollama ollama pull qwen:7bSau khi tải xuống hoàn tất, bạn có thể cần khởi động lại Web UI để nhận diện mô hình mới:

docker-compose stop open-webui

docker-compose rm -f open-webui

docker-compose up -d open-webuiLàm mới trang giao diện chat, bạn sẽ thấy các mô hình mới có sẵn trong menu thả xuống, cho phép tương tác với mô hình ngôn ngữ lớn cục bộ của mình.

Truy cập cơ sở dữ liệu Supabase

Truy cập giao diện quản lý cơ sở dữ liệu tại http://db.yourdomain.com. Đăng nhập bằng người dùng postgres và POSTGRES_PASSWORD đã đặt trong tệp .env. Tại đây, bạn có thể quản lý bảng và dữ liệu, đảm bảo tính toàn vẹn và bảo mật.

Kết luận

Bạn đã hoàn tất thiết lập hạ tầng tác nhân AI riêng tư! Giờ đây, bạn có thể tự do xây dựng quy trình tự động hóa trong N8N, tương tác với LLM riêng tư qua giao diện chat và quản lý dữ liệu an toàn trong Supabase. Hệ thống mạnh mẽ này mở ra khả năng xây dựng ứng dụng AI tinh vi mà không lo quyền riêng tư dữ liệu hay chi phí API. Đây là bước đột phá để bạn làm chủ công nghệ AI cục bộ.

Câu hỏi thường gặp (FAQ)

Tại sao nên xây dựng hệ thống AI trên VPS thay vì máy tính cá nhân?

Xây dựng AI trên VPS mang lại nhiều lợi thế: truy cập 24/7, đa người dùng, thiết lập chuyên nghiệp (tên miền, SSL), và bảo mật dữ liệu hoàn toàn (không gửi bên thứ ba). Máy tính cá nhân thường không đủ tài nguyên liên tục và độ tin cậy cho ứng dụng AI đòi hỏi cao.

Cấu hình VPS tối thiểu cần thiết để chạy hệ thống AI này là gì?

Chúng tôi khuyến nghị cấu hình khởi điểm: ít nhất 4 lõi vCPU, 16 GB RAM và 200 GB NVMe. Mức này đảm bảo các mô hình AI và dịch vụ hoạt động hiệu quả. Nếu chạy nhiều mô hình lớn hoặc khối lượng công việc nặng, bạn có thể cần nâng cấp.

Làm thế nào để thêm các mô hình AI mới vào hệ thống sau khi đã cài đặt?

Để thêm mô hình AI mới, quay lại terminal VPS. Dùng lệnh docker-compose exec ollama ollama pull <tên_mô_hình> để tải qua Ollama. Sau khi tải, bạn có thể cần khởi động lại dịch vụ Open Web UI bằng các lệnh docker-compose stop open-webui, docker-compose rm -f open-webui, và docker-compose up -d open-webui để giao diện chat nhận diện mô hình mới.